En la era digital en la que vivimos, la cantidad de información disponible en línea es abrumadora. Desde **artículos informativos** hasta tablas de datos, pasando por publicaciones en redes sociales, hay un sinfín de datos que pueden ser valiosos para diversas industrias. Aquí es donde entran los **scripts de extracción web**, herramientas esenciales para recoger y procesar información de sitios web de manera automatizada y eficiente. Este recurso no solo ayuda a la recopilación de datos, sino que también transforma la manera en que las organizaciones toman decisiones basadas en hechos concretos.

En este artículo, exploraremos diversos aspectos de los **scripts de extracción web**, comenzando por su definición y funciones. Dissectaremos cómo funcionan, los diferentes tipos existentes y las aplicaciones que pueden tener en el análisis de datos. Además, revisaremos las mejores prácticas para su implementación y los desafíos que se pueden encontrar al utilizar estas herramientas. A través de este recorrido, buscamos ofrecerte una comprensión profunda y práctica sobre el tema para que puedas aplicar este conocimiento en tus proyectos o en tu carrera profesional.

Comprendiendo los scripts de extracción web

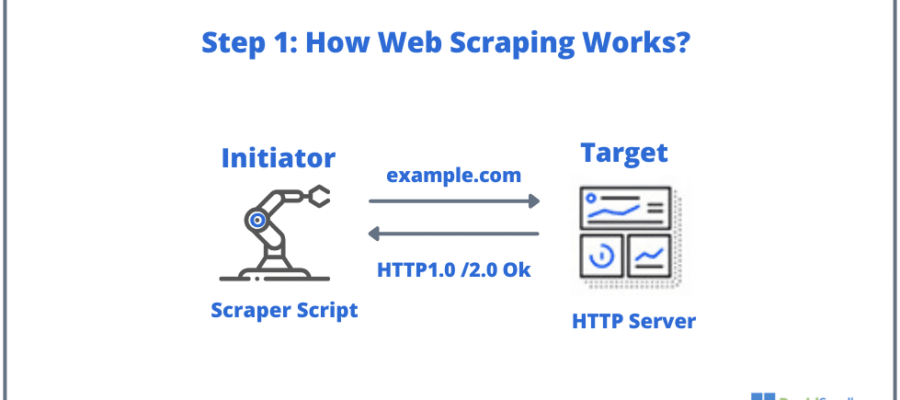

Los scripts de extracción web son programas diseñados para navegar por la web, recopilar datos de diversas fuentes y proporcionar información útil de manera estructurada. Estos scripts pueden ser escritos en varios lenguajes de programación, como Python, JavaScript o Ruby, y permiten a los usuarios acceder a contenido que podría ser difícil de recopilar manualmente. Utilizando técnicas de **web scraping**, estos scripts hacen solicitudes a servidores web, recuperan el código HTML de las páginas y luego extraen la información relevante.

Al realizar la extracción, los scripts pueden buscar etiquetas HTML específicas, como <h1> para títulos, <p> para párrafos o cualquier otro elemento que contenga datos de interés. La capacidad de automatizar este proceso ahorra un tiempo valioso, especialmente cuando se trabaja con grandes volúmenes de información. Sin embargo, es crucial tener en cuenta la legalidad y la ética que rodea al scraping. Algunos sitios web prohíben la extracción de su contenido a través de sus términos de servicio, por lo que es esencial siempre revisar estas normas antes de proceder.

Optimización de scripts de programación para mejorar rendimiento

Optimización de scripts de programación para mejorar rendimientoTipos de scripts de extracción web

Existen diferentes tipos de **scripts de extracción web** que se utilizan dependiendo de los objetivos específicos que se intentan alcanzar. Uno de los tipos más comunes son los scripts de **raspado estático**. Este enfoque implica extraer datos de páginas web que su contenido no cambia dinámicamente. Por ejemplo, un sitio de comercio electrónico que muestra un catálogo de productos es ideal para este tipo de script. La extracción se lleva a cabo leyendo el HTML estático, lo que facilita la captura de información estructurada.

Por otro lado, también existen los scripts de **raspado dinámico**. Estos son diseñados para interactuar con contenido que utiliza JavaScript para cargar información. Muchos sitios modernos dependen de este enfoque, donde los datos no son visibles de inmediato en el HTML inicial. En estos casos, los scripts deben simular el comportamiento humano, como el desplazamiento por la página o la interacción con formularios, para acceder a la información deseada. Esto puede requerir herramientas como **Selenium** o **Puppeteer**, que permiten la automatización de navegadores. Ambas opciones amplían enormemente las capacidades de extracción, pero también requieren un conocimiento más profundo en programación y manejo de herramientas.

Aplicaciones de los scripts de extracción web en el análisis de datos

El uso de **scripts de extracción web** en **análisis de datos** es vasto y variado. Las organizaciones pueden utilizar esta tecnología para comparar precios, llevando a cabo un monitoreo constante de la competencia en el mercado. Al extraer y analizar los precios de productos similares en diferentes sitios, las empresas pueden ajustar sus estrategias de precios de manera efectiva. Este tipo de análisis permite a las organizaciones ser más competitivas y reactiva ante las fluctuaciones del mercado.

Además, los scripts de extracción web están siendo utilizados para analizar tendencias de redes sociales. La capacidad de extraer datos de plataformas como Twitter y Facebook puede proporcionar una visión profunda de lo que el público está diciendo sobre una marca, un producto o cualquier tema en particular. A través de estos datos, las empresas pueden desarrollar estrategias de marketing más efectivas, alineándose mejor con las expectativas y deseos de sus clientes potenciales.

Otra aplicación relevante es el análisis de reseñas online. Las opiniones y comentarios de los clientes pueden tener una influencia significativa en las decisiones de compra. Mediante la extracción de comentarios de diferentes sitios de reseñas, las empresas pueden identificar patrones y comprender las áreas de mejora en sus productos o servicios. Esto genera un ciclo de retroalimentación positivo que puede contribuir enormemente a la satisfacción del cliente a largo plazo.

Recomendado: Impacto y Relevancia de los Scripts en el Desarrollo Ágil

Impacto y Relevancia de los Scripts en el Desarrollo ÁgilMejores prácticas para implementar scripts de extracción web

Cuando se habla de **implementación de scripts de extracción web**, es fundamental seguir ciertas mejores prácticas para garantizar resultados óptimos y éticos. Un aspecto crucial es la planificación del scraping; es importante definir claramente qué datos se desean extraer y la frecuencia con la que se llevará a cabo la recopilación. Esto ayudará a configurar correctamente el script y evitará que el servidor web se vea abrumado por solicitudes excesivas.

También se deben respetar las restricciones de los **robots.txt** de los sitios web. Este archivo es utilizado por los propietarios de sitios para indicar qué partes de su web pueden ser accedidas por bots y crawlers. Ignorar estas directrices puede no solo perjudicar la relación entre tu organización y el propietario del sitio, sino que además podría resultar en la prohibición de acceso o incluso en acciones legales.

Otro punto importante es manejar adecuadamente los errores y las excepciones que puedan surgir durante el proceso de extracción. Los sitios web pueden cambiar su estructura sin previo aviso, lo que puede hacer que el script falle. Es esencial construir un mecanismo que gestione estos errores y que permita la adaptabilidad. A menudo, esto puede implicar realizar pruebas continuas y mantener el script actualizado.

Desafíos en la utilización de scripts de extracción web

El uso de **scripts de extracción web** puede ser muy beneficioso, pero también presenta varios desafíos. Uno de los principales obstáculos es la **variabilidad en la estructura de las páginas web**. Como cada sitio organiza su información de manera diferente, un script que funciona para un sitio específico puede fallar al aplicarse a otro. Esto requiere constantemente ajustes y actualizaciones en el código, lo que puede ser un esfuerzo arduo.

La legalidad también es un tema delicado. La extracción de información sin el consentimiento del propietario del sitio puede ser considerada violación a derechos de autor y propiedades intelectuales. Es esencial estar al tanto de las leyes y regulaciones que pueden influir en la práctica del scraping. En algunos países, el scraping de datos personales sin autorización puede resultar en sanciones legales severas.

Recomendado: Scripts multiplataforma: soluciones simples para diversos OS

Scripts multiplataforma: soluciones simples para diversos OSReflexiones finales sobre la extracción web

Los **scripts de extracción web** representan una herramienta poderosa en el mundo del análisis de datos. Desde sus capacidades para acceder a información valiosa hasta su posible uso en la toma de decisiones estratégicas, los beneficios son palpables. Sin embargo, como hemos discutido, la implementación exitosa de estas herramientas requiere una comprensión clara tanto de las técnicas como de las responsabilidades legales y éticas relacionadas. Al final, el dominio en el uso de scripts de extracción web puede ofrecer ventajas competitivas significativas, pero siempre debe ser realizado con integridad y respeto hacia los demás. Así que, al considerar la implementación de estas herramientas, reflexiona sobre los impactos a largo plazo que pueden tener tanto en tu negocio como en la comunidad en general.